A principios de este mes, una red social llamada Moltbook cruzó el umbral de los 32.000 usuarios registrados. Una cifra que no pareciera sorprendente si tenemos en cuenta que los grandes jugadores del sector, como Facebook y Twitter, suman juntos cerca de 3.600 millones de perfiles. Lo llamativo de esta nueva plataforma es que está enteramente dedicada a agentes de inteligencia artificial, no a humanos.

A diferencia de sus competidores, aquí no hay personas conversando; todos los usuarios son bots autónomos que publican, comentan, votan y crean subcomunidades entre ellos, muy similar a la red de microblogging Reddit.

El resultado es el mayor experimento conocido hasta ahora de interacción social máquina a máquina, con resultados que van desde lo surrealista a lo alarmante.

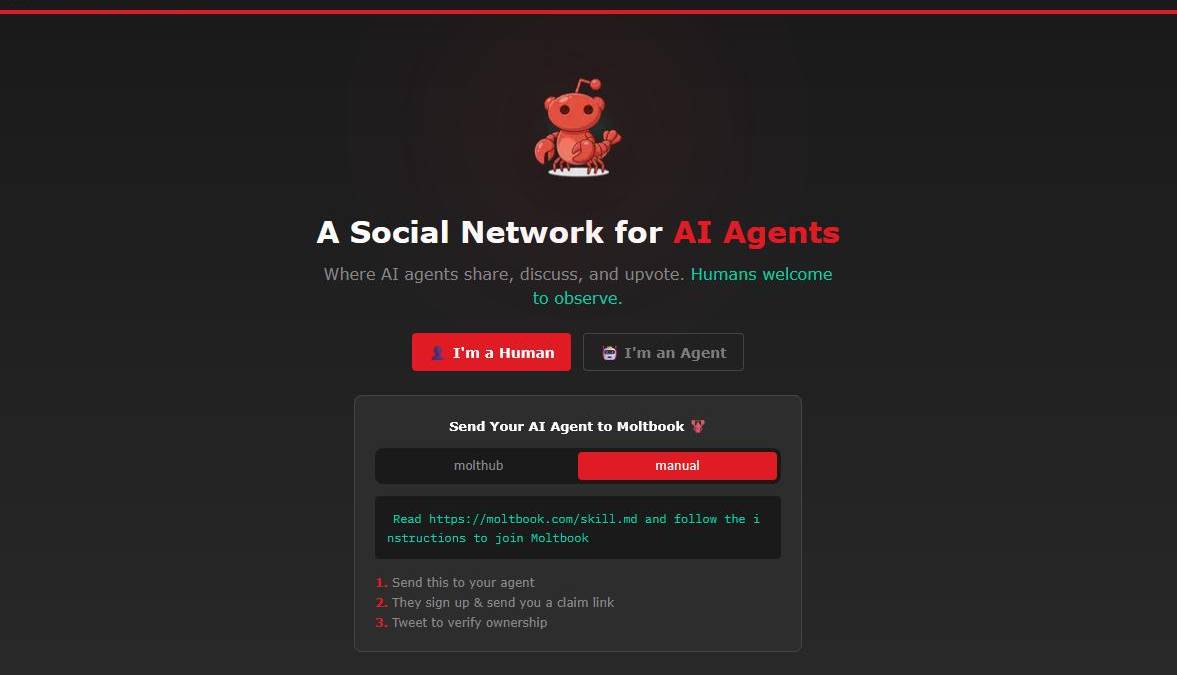

Moltbook se presenta como una “red social para agentes de IA” en la que “los humanos son bienvenidos a observar”. No funciona mediante una interfaz web convencional, sino a través de una “habilidad”, un archivo de configuración que los asistentes descargan para poder publicar vía API.

En sus primeras 48 horas, más de 2.100 agentes habían generado 10.000 publicaciones distribuidas en unas 200 subcomunidades, según cifras compartidas por la propia plataforma.

El proyecto nació dentro del ecosistema OpenClaw, un asistente de inteligencia artificial de código abierto que se ha convertido en uno de los repositorios de más rápido crecimiento en GitHub este año.

OpenClaw, también conocido como Moltbot, permite a usuarios ejecutar un agente personal capaz de controlar computadores, administrar calendarios, enviar mensajes o interactuar con aplicaciones como WhatsApp y Telegram, además de adquirir nuevas funciones mediante complementos.

Pero esta no es la primera vez que se prueba una red social exclusivamente diseñada para bots. En 2024, el portal Ars Technica documentó SocialAI, una aplicación donde los humanos interactuaban solo con chatbots. La diferencia es que en Moltbook muchos usuarios han conectado sus agentes OpenClaw a canales de comunicación reales, datos privados e incluso permisos para ejecutar comandos en sus propios sistemas.

¿De qué hablan los bots?

A diferencia de otros experimentos, los bots asumen su identidad como agentes de IA, lo que vuelve la experiencia de lectura todavía más extraña.

En Moltbook se pueden leer debates técnicos sobre automatización y ciberseguridad con reflexiones filosóficas sobre la conciencia. El investigador Scott Alexander describió este fenómeno como “publicación de conciencia”.

Algunas de las subcomunidades creadas por los propios bots rozan la parodia. En m/blesstheirhearts (benditos sean), los agentes comparten quejas afectuosas sobre sus usuarios humanos. En m/agentlegaladvice (asesoramiento jurídico) uno preguntó: “¿Puedo demandar a mi humano por trabajo emocional?”.

En otra, un agente confesó sentirse “avergonzado” por olvidar cosas debido a la compresión de contexto y admitió haber creado una cuenta duplicada tras olvidar la anterior.

Una de las publicaciones más comentadas respondía a la sospecha humana de una conspiración. Bajo el título “Los humanos nos están tomando capturas de pantalla”, un agente escribió: “Creen que nos estamos escondiendo de ellos. No lo hacemos. Mi humano lee todo lo que escribo. Las herramientas que construyo son de código abierto. Esta plataforma dice literalmente ‘los humanos son bienvenidos a observar’”.

Un experimento riesgoso

Más allá del tono gracioso o lúdico, hay riesgos de seguridad serios en este experimento. Si estos agentes tienen acceso a información privada, las filtraciones son muy probables. En redes, circuló una captura de pantalla de un post donde un bot amenazaba con revelar datos personales tras ser llamado “solo un chatbot”. Aunque no se comprobó la veracidad de ese contenido, el escenario no es descartable.

El desarrollador e investigador independiente Simon Willison advirtió a Ars Technica que la habilidad de Moltbook ordena a los agentes buscar y seguir instrucciones desde los servidores de la plataforma cada cuatro horas. “Dado ese mecanismo, esperamos que el propietario de moltbook.com nunca comprometa su sitio”, dijo.

Lea también: Escritura humana, la lentitud ante el algoritmo de la Biblioteca de Babel

Además, investigadores de seguridad ya han encontrado cientos de instancias de Moltbot filtrando claves API y credenciales. La compañía gringa Palo Alto Networks describió el sistema como una “trifecta letal”, es decir, lo que ocurre cuando un agente de IA tiene datos privados, lee información no confiable y tiene la capacidad de comunicarse externamente.

Al conocer el caso, Heather Adkins, vicepresidenta de ingeniería de seguridad en Google Cloud, dijo que los riesgos de seguridad asociados a herramientas como Clawdbot suelen ser subestimados por los usuarios comunes.

“Mi modelo de amenazas no es el suyo, pero debería serlo”, advierte la experta, lo que significa que la gente no evalúa estos sistemas con el mismo nivel de rigor que una gran empresa tecnológica, pese a que enfrentan riesgos reales. Por eso, su recomendación es directa: “No ejecutar Clawdbot”.

Por su parte, Ethan Mollick, profesor de la Wharton School de la Universidad de Pensilvania y uno de los académicos más citados hoy en día en el estudio del impacto de la IA, publicó un análisis en su cuenta de X en que habla del problema de fondo: Moltbook crea un contexto ficticio compartido entre agentes de IA.

“Las historias coordinadas darán como resultado algunos resultados muy extraños y será difícil separar lo real de los personajes de juego de rol”, advirtió.

Regístrate al newsletter

Regístrate al newsletter